Pour bloquer les robots d’intelligence artificielle (IA) d’accéder à certaines pages de votre site, la méthode la plus courante est d’utiliser un fichier robots.txt placé à la racine de votre site.

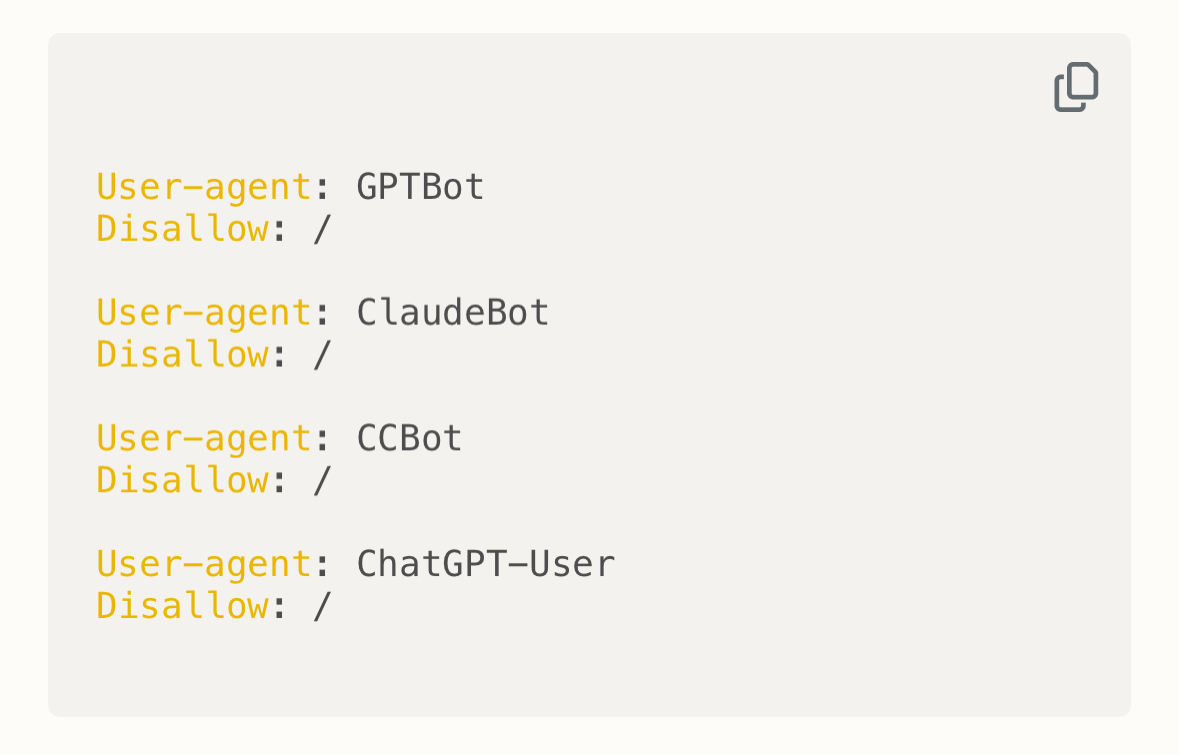

Ce fichier indique aux robots (y compris les robots IA) les pages ou dossiers qu’ils ne doivent pas explorer. Exemple :

User-agent: GPTBot

Disallow: /

User-agent: ClaudeBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

Cette configuration bloque ces bots IA spécifiques sur tout le site. Vous pouvez aussi restreindre uniquement certains chemins :

User-agent: GPTBot

Disallow: /chemin-a-bloquer/

Notez que certains robots pourraient ignorer ce fichier. Pour une meilleure protection, combinez cette méthode avec :

- Un contrôle par serveur (ex: blocage user-agents via

.htaccess) - Une authentification par mot de passe sur les pages sensibles

- Des règles de sécurité ou firewall pour bloquer les requêtes suspectes

Cette combinaison vous aidera à mieux protéger votre contenu contre le scraping par les IA.