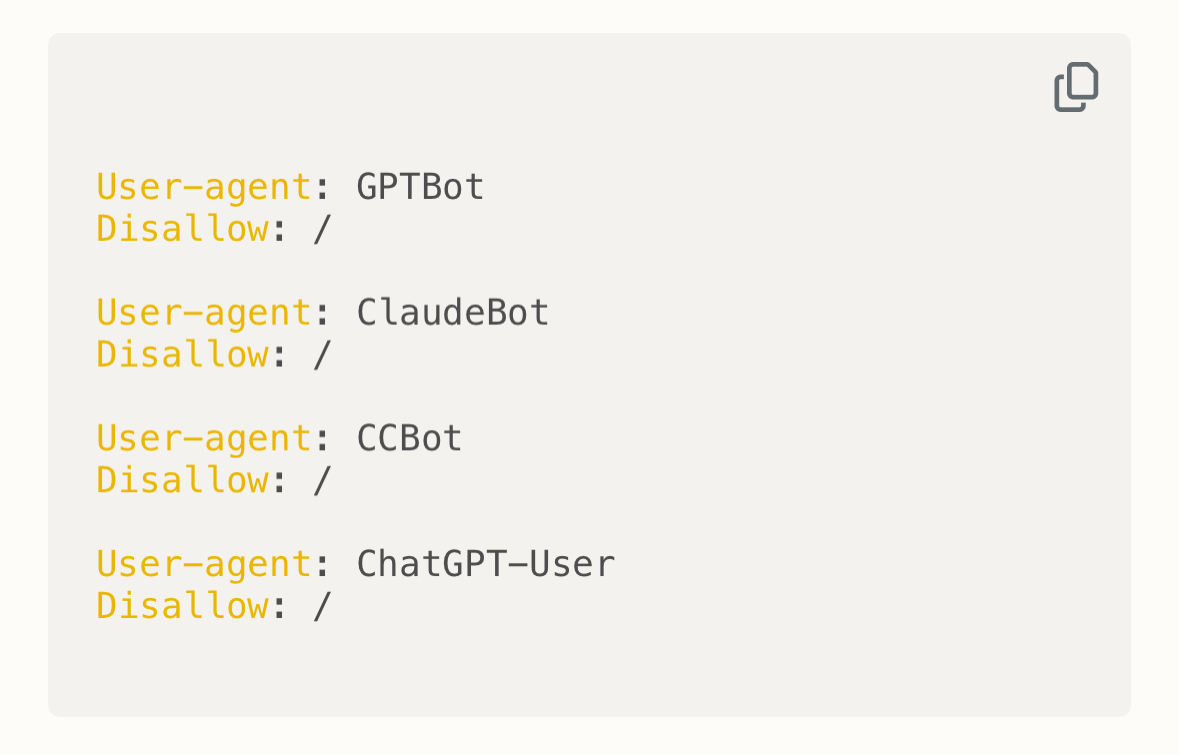

Pour bloquer les robots d’intelligence artificielle (IA) d’accéder à certaines pages de votre site, la méthode la plus courante est d’utiliser un fichier robots.txt placé à la racine de votre site. Ce fichier indique aux robots (y compris les robots IA) les pages ou dossiers qu’ils ne doivent pas explorer. Exemple : User-agent: GPTBot Disallow: […]